在人工智能領(lǐng)域,一項(xiàng)由牛津大學(xué)劉世偉教授領(lǐng)銜的國(guó)際合作研究近日引起了廣泛關(guān)注。該研究聯(lián)合了西湖大學(xué)、埃默里大學(xué)、大連理工大學(xué)及薩里大學(xué)等多家頂尖學(xué)府,其突破性成果已于2025年7月發(fā)表于人工智能領(lǐng)域的權(quán)威期刊上。論文題為《大型語(yǔ)言模型中的深度困境》,感興趣的讀者可訪問(wèn)arXiv:2502.05795v2獲取全文。

該研究深入探討了當(dāng)前最先進(jìn)的大型語(yǔ)言模型(例如ChatGPT、Claude等)在訓(xùn)練過(guò)程中的一個(gè)奇特現(xiàn)象:模型層次越深,后續(xù)層級(jí)的重要性反而越小。為了形象地說(shuō)明這一問(wèn)題,研究團(tuán)隊(duì)將其比喻為一座智慧大樓,其中每一層本應(yīng)各司其職,共同為最終智能輸出貢獻(xiàn)力量。然而,他們驚人地發(fā)現(xiàn),大樓的上半部分“工匠”幾乎在消極怠工,即便移除這些層級(jí),模型的整體表現(xiàn)也幾乎不受影響。

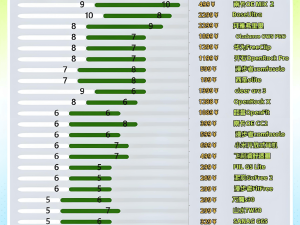

為了驗(yàn)證這一現(xiàn)象的普遍性,研究團(tuán)隊(duì)選取了當(dāng)前流行的多個(gè)大型語(yǔ)言模型家族作為測(cè)試對(duì)象,包括Llama、Mistral、DeepSeek和Qwen系列。他們巧妙地設(shè)計(jì)了一系列實(shí)驗(yàn),通過(guò)逐一移除模型的不同層級(jí),觀察并記錄模型性能的變化。實(shí)驗(yàn)結(jié)果令人震驚:移除深層的多個(gè)層級(jí)后,模型的表現(xiàn)幾乎未受影響,甚至在某些情況下略有提升;相反,移除淺層的任何一層都會(huì)導(dǎo)致模型性能顯著下降。

研究團(tuán)隊(duì)將這一奇特現(xiàn)象命名為“深度困境”。這一名稱形象地揭示了當(dāng)前大型語(yǔ)言模型訓(xùn)練中的一個(gè)根本矛盾:盡管我們投入了大量計(jì)算資源來(lái)訓(xùn)練更深的模型,期望獲得更強(qiáng)的能力,但實(shí)際上,越深的層級(jí)對(duì)模型的貢獻(xiàn)越小,仿佛被某種無(wú)形的困境所束縛。

為了深入理解這一現(xiàn)象,研究團(tuán)隊(duì)進(jìn)一步分析了層與層之間表示的相似性。他們利用角度距離這一數(shù)學(xué)工具來(lái)測(cè)量不同層級(jí)的輸出相似性。結(jié)果表明,在深層網(wǎng)絡(luò)中,相鄰層級(jí)的輸出幾乎完全相同,這意味著這些層級(jí)只是在重復(fù)前面層級(jí)的工作,沒(méi)有產(chǎn)生任何新的有用信息。

研究團(tuán)隊(duì)還對(duì)比了兩種不同的網(wǎng)絡(luò)架構(gòu)設(shè)計(jì):現(xiàn)代大型語(yǔ)言模型普遍采用的“前置層歸一化”(Pre-LN)與較早模型使用的“后置層歸一化”(Post-LN)。通過(guò)對(duì)比實(shí)驗(yàn),他們發(fā)現(xiàn)采用Pre-LN的模型更容易出現(xiàn)深度困境現(xiàn)象,而采用Post-LN的模型則表現(xiàn)出相反的趨勢(shì):深層比淺層更重要。這一發(fā)現(xiàn)為理解深度困境的根源提供了重要線索。

為了揭示深度困境的理論根源,研究團(tuán)隊(duì)深入探討了Pre-LN架構(gòu)的工作原理。他們發(fā)現(xiàn),在Pre-LN架構(gòu)中,隨著網(wǎng)絡(luò)層數(shù)的增加,輸出的方差會(huì)呈指數(shù)級(jí)增長(zhǎng)。這種增長(zhǎng)導(dǎo)致深層網(wǎng)絡(luò)的梯度趨近于單位矩陣,使得這些層級(jí)幾乎變成了“透明層”,沒(méi)有進(jìn)行任何有意義的轉(zhuǎn)換。為了直觀理解這一概念,研究團(tuán)隊(duì)用烹飪過(guò)程進(jìn)行了類比:如果后續(xù)步驟只是簡(jiǎn)單的“保溫”操作,那么無(wú)論進(jìn)行多少步驟,最終的味道都不會(huì)有太大變化。

面對(duì)這一棘手問(wèn)題,研究團(tuán)隊(duì)提出了一個(gè)簡(jiǎn)潔而有效的解決方案:層歸一化縮放(LNS)。這一方法的核心思想是通過(guò)給每一層的輸出乘以一個(gè)與層深度相關(guān)的縮放因子來(lái)控制方差的增長(zhǎng)。縮放因子等于當(dāng)前層深度的平方根的倒數(shù),即1/√l,其中l(wèi)為層的索引。這種設(shè)計(jì)確保了每一層都能發(fā)揮其應(yīng)有的作用,避免了深層網(wǎng)絡(luò)的“偷懶”現(xiàn)象。

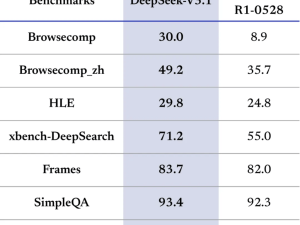

為了驗(yàn)證LNS的有效性,研究團(tuán)隊(duì)進(jìn)行了大規(guī)模的實(shí)驗(yàn)驗(yàn)證。實(shí)驗(yàn)涵蓋了從小型模型到大型模型的各種規(guī)模,結(jié)果顯示LNS在所有測(cè)試規(guī)模上都顯著優(yōu)于傳統(tǒng)的歸一化方法。特別是在工業(yè)級(jí)別的訓(xùn)練規(guī)模下,LNS仍然表現(xiàn)出顯著的性能提升。

研究團(tuán)隊(duì)還進(jìn)行了下游任務(wù)的微調(diào)實(shí)驗(yàn)。他們使用Commonsense170K數(shù)據(jù)集在八個(gè)不同的推理任務(wù)上測(cè)試了經(jīng)過(guò)LNS預(yù)訓(xùn)練的模型。結(jié)果顯示,使用LNS預(yù)訓(xùn)練的模型在微調(diào)后的表現(xiàn)也明顯優(yōu)于傳統(tǒng)方法。這表明LNS不僅改善了預(yù)訓(xùn)練效果,還增強(qiáng)了模型的通用學(xué)習(xí)能力。

為了深入理解LNS的工作機(jī)制,研究團(tuán)隊(duì)還進(jìn)行了詳細(xì)的分析實(shí)驗(yàn)。他們驗(yàn)證了LNS確實(shí)能夠有效控制輸出方差,并分析了LNS對(duì)層間表示多樣性的影響。實(shí)驗(yàn)結(jié)果表明,LNS成功地讓每一層都發(fā)揮了應(yīng)有的作用,提高了模型的整體性能。

LNS的實(shí)現(xiàn)既簡(jiǎn)單又巧妙。它不需要引入額外的可學(xué)習(xí)參數(shù)或調(diào)整任何超參數(shù),只需在每個(gè)層歸一化操作的輸出后乘以相應(yīng)的縮放因子即可。這種設(shè)計(jì)既保持了Pre-LN的訓(xùn)練穩(wěn)定性優(yōu)勢(shì),又解決了深層網(wǎng)絡(luò)效果不佳的問(wèn)題。

值得注意的是,研究團(tuán)隊(duì)還發(fā)現(xiàn)LNS與某些初始化策略可能存在沖突。他們建議在使用LNS時(shí)移除縮放初始化以獲得最佳性能提升。研究團(tuán)隊(duì)還將LNS應(yīng)用到視覺(jué)Transformer中進(jìn)行了初步探索,發(fā)現(xiàn)LNS的具體實(shí)現(xiàn)可能需要根據(jù)不同的模型架構(gòu)和任務(wù)進(jìn)行調(diào)整。

這項(xiàng)研究的實(shí)際應(yīng)用價(jià)值巨大。當(dāng)前訓(xùn)練大型語(yǔ)言模型需要消耗大量計(jì)算資源和能源,而深度困境意味著其中相當(dāng)一部分投資實(shí)際上是浪費(fèi)的。LNS的引入能夠提高訓(xùn)練效率和最終性能,降低計(jì)算成本。

對(duì)于工業(yè)界來(lái)說(shuō),這意味著在相同的計(jì)算預(yù)算下可以獲得更好的模型性能,或者在保持性能不變的情況下顯著降低計(jì)算成本。考慮到大型語(yǔ)言模型的訓(xùn)練成本高昂,這種效率提升的經(jīng)濟(jì)價(jià)值不言而喻。

對(duì)于研究界來(lái)說(shuō),這項(xiàng)工作開(kāi)啟了重新審視現(xiàn)有架構(gòu)設(shè)計(jì)的新視角。它表明,即使是被廣泛采用的設(shè)計(jì)選擇也可能存在根本性缺陷,需要更深入的理論分析來(lái)發(fā)現(xiàn)和解決。研究團(tuán)隊(duì)的工作為未來(lái)模型架構(gòu)的設(shè)計(jì)提供了重要指導(dǎo),強(qiáng)調(diào)了在追求更深、更大的模型時(shí),必須仔細(xì)考慮深度對(duì)模型行為的影響。